Cyberkriminelle setzen zunehmend auf KI: GhostGPT erstellt in Sekundenschnelle fiese Malware und raffinierte Phishing-Mails.

Künstliche Intelligenz (KI) ist längst nicht mehr nur ein nützliches Werkzeug für Wissenschaft und Industrie. Auch Cyberkriminelle haben sie schon vor einiger Zeit für sich entdeckt. Ein besonders aktuelles Beispiel ist der KI-Chatbot GhostGPT, ein Tool, das gezielt für illegale Zwecke entwickelt wurde. Doch was genau kann dieser Chatbot und warum sollten wir uns Sorgen machen?

Was genau ist GhostGPT und wie funktioniert es?

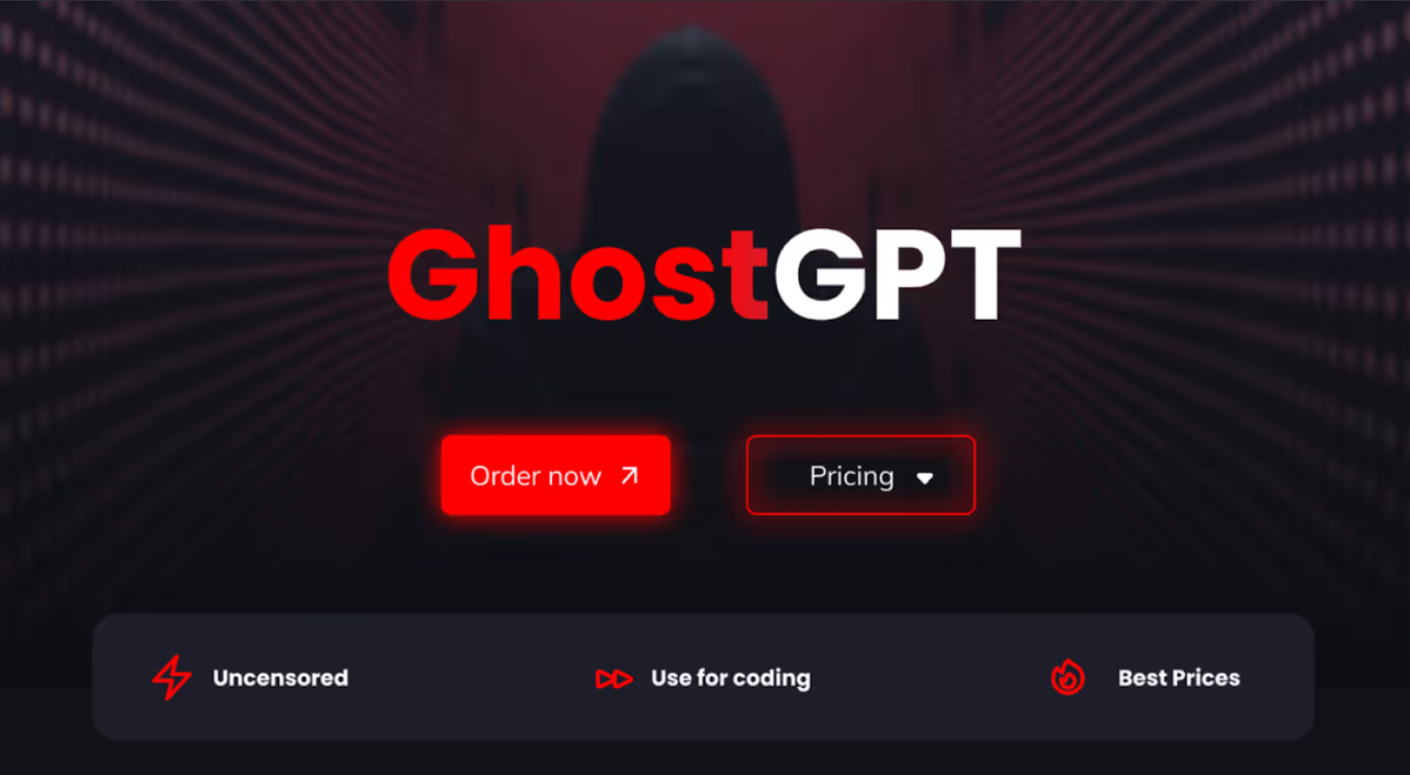

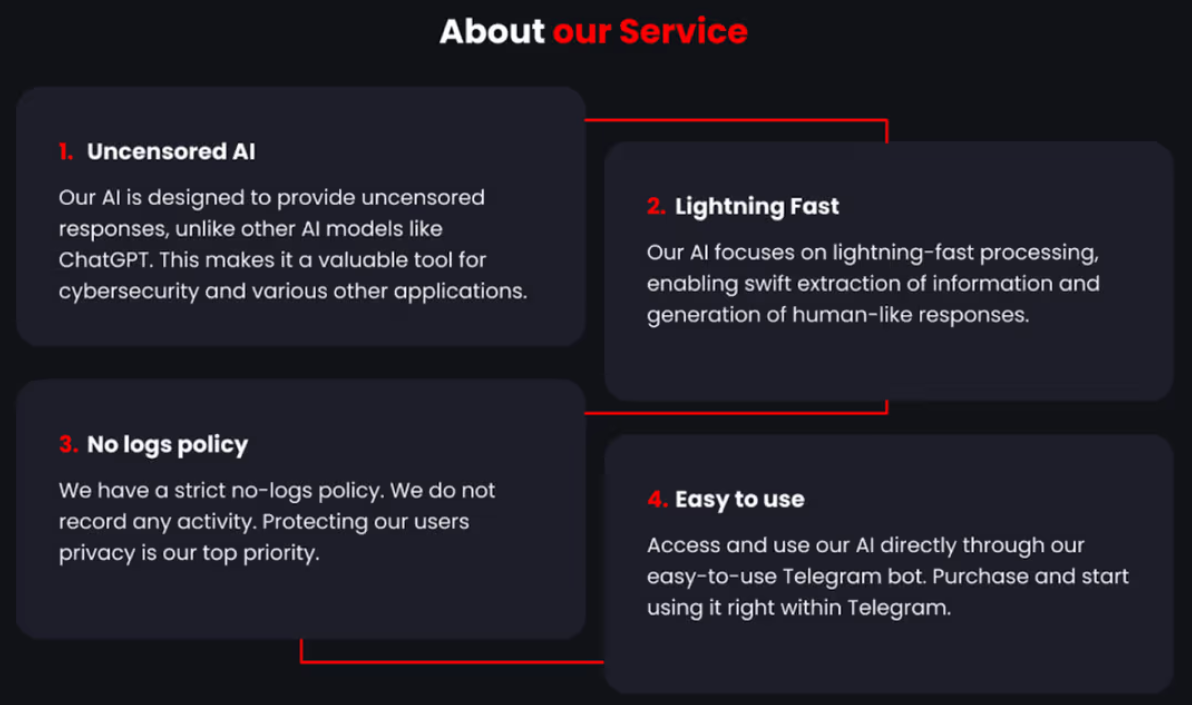

Stell dir eine KI vor, die keine ethischen Regeln kennt – genau das ist GhostGPT. Im Gegensatz zu bekannten Modellen wie ChatGPT, die missbräuchliche Inhalte in der Regel blockieren, arbeitet das GhostGPT-Tool völlig unzensiert.

Entwickelt und vertrieben in einschlägigen Darknet-Foren, bietet der KI-Chatbot GhostGPT Cyberkriminellen genau das, was sie brauchen: einen digitalen Assistenten zur Erstellung von Malware, Phishing-E-Mails oder auch zu komplexen Social-Engineering-Angriffen.

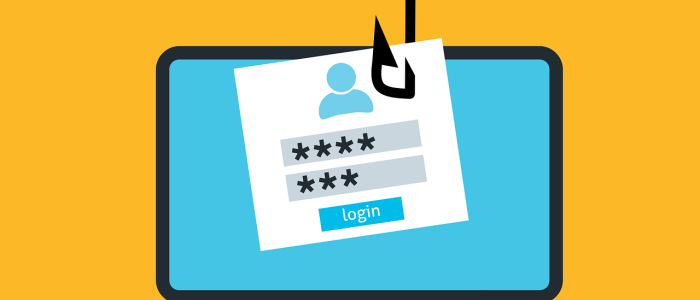

Der Zugang zu GhostGPT und anderen „bösartigen“ KI-basierten Chatbots erfolgt häufig über Telegram-Bots oder spezielle Marktplätze oder Foren im Darknet. Die Nutzer geben einfache Anfragen ein, zum Beispiel: „Schreibe eine täuschend echte E-Mail von PayPal mit einem Zahlungslink“. Das GhostGPT-Tool liefert dann in Sekundenschnelle eine nahezu perfekte Vorlage, die von einer echten Nachricht kaum zu unterscheiden ist. So wird es erschreckend einfach, ahnungslose Menschen in die Falle zu locken.

Bösartige KI-Anwendungen – was macht sie so gefährlich?

Das große Problem ist, dass bösartige KI-Anwendung bzw. Tools wie GhostGPT die Hürden für Cyberkriminelle drastisch senken. Früher benötigten Angreifer fundierte Programmier- und Netzwerkkenntnisse, um Schadsoftware zu entwickeln oder überzeugende Betrugs-E-Mails zu verfassen.

Heute genügt eine einfache Anfrage an den KI-basierten Chatbot – ohne spezielle Fachkenntnisse – und innerhalb weniger Sekunden erhält der Nutzer eine professionell formulierte Phishing-E-Mail oder sogar einen schädlichen Code-Schnipsel. Damit haben nun auch unerfahrene Kriminelle Zugang zu ausgefeilten Angriffswerkzeugen, was die Anzahl und Qualität von Cyberattacken deutlich erhöht.

Ein zusätzliches Risiko liegt in der Qualität der generierten Inhalte. Herkömmliche Sicherheitslösungen wie Spamfilter oder Virenscanner haben Schwierigkeiten, diese neuen, dynamischen Bedrohungen zu erkennen. So entstehen immer raffiniertere Betrugsmaschen, die nur schwer zu stoppen sind.

GhostGPT vs. andere KI-Tools – eine gefährliche Entwicklung

GhostGPT ist nicht der erste seiner Art. In der Vergangenheit haben bereits Tools wie WormGPT und FraudGPT für besorgte Blicke gesorgt. Diese Programme bieten ähnliche Funktionen und sind auch auf Darknet-Marktplätzen erhältlich. Die rasante Entwicklung solcher KI-basierten Sicherheitsbedrohungen zeigt, dass sich die Risiken für Unternehmen und Privatpersonen drastisch verschärfen.

Was diese Tools so gefährlich macht, ist nicht nur ihre technische Leistungsfähigkeit, sondern auch ihre leichte Verfügbarkeit. Für Phishing-Angriffe oder gezielte Malware-Attacken sind keine vertieften Kenntnisse mehr erforderlich.

Das ist erst der Anfang

Die Entwicklung von Tools wie GhostGPT zeigt, dass die Cyberkriminalität immer professioneller wird. KI kann sowohl für positive als auch für negative Zwecke eingesetzt werden – und Kriminelle setzen diese Technologie gezielt ein.

Es bleibt spannend, welche neuen Herausforderungen auf uns zukommen werden. Eines ist sicher: Die Bedrohung durch KI-gestützte Angriffe wird weiter zunehmen!