Hält diese KI, was der Hersteller verspricht? Wir haben die lokale KI AMD GAIA für euch ausprobiert. Sie ist für PCs mit einer NPU optimiert.

In der griechischen Mythologie galt Gaia als die Urgöttin der Erde. Der Chiphersteller AMD verspricht, dass bei seiner Open-Source-Lösung die Reaktionszeit kürzer und der Energieverbrauch geringer als bei cloudbasierten Anwendungen sein soll. Künstliche Intelligenz (KI) gilt als eine der wichtigsten Technologien unserer Zeit. Bisher lief sie meist in der Cloud. Also in großen Rechenzentren von Unternehmen wie Microsoft, Amazon oder Facebook. Diese stellen uns riesige Sprachmodelle zur Verfügung, die tagtäglich millionenfach genutzt werden. Mit AMD GAIA will der Hersteller dieses Prinzip ändern.

Das Unternehmen hat eine Plattform vorgestellt, die es ermöglicht, Sprachmodelle direkt auf dem eigenen Rechner auszuführen. Zusammen mit der grafischen Oberfläche GAIA UI soll die Nutzung so einfach werden, dass auch Einsteiger schnell Zugang zu leistungsfähiger KI erhalten.

AMD GAIA ist eine offene Plattform für Sprachmodelle.

AMD GAIA ist ein Open-Source-Projekt von AMD. Dafür wurde ein Fork von Open-Web-UI erstellt, der den Zugang zwar einfach ermöglicht, aber leider gleichzeitig die Möglichkeit nimmt, die LLMs im Netzwerk ordentlich zu teilen. Diese lokale KI-Lösung kann man von dort herunterladen.

Im Unterschied zu den klassischen Cloud-Lösungen bleiben die Daten dabei auf dem eigenen Gerät. AMD sieht darin gleich zwei Vorteile: Einerseits werden sensible Informationen nicht an externe Server übertragen. Zum anderen sinkt die Verzögerung, da der eigene Computer die Anfragen direkt verarbeitet. Für mich ist ein weiterer Vorteil, dass ich alle Anfragen im Klartext sehen kann. Da lokale KIs wie Gaia und FlowLM, die wir im zweiten Teil behandeln, nicht mit dem Internet verbunden sind, können sie keine Echtzeitdaten beziehen. Man kann damit also keine Wettervorhersagen oder mögliche Zugverspätungen abfragen. Der große Vorteil ist jedoch, dass potenzielle Suizide, wie sie bei den Gesprächen mit ChatGPT passiert sind, nicht möglich sind. Dazu sind die Offline-LLMs aufgrund ihrer eingeschränkten Gesprächsfähigkeit einfach nicht in der Lage.

Lemonade SDK dient als Grundlage

Technisch basiert AMD GAIA auf dem sogenannten Lemonade SDK, einem Software-Baukasten für KI-Modelle. Dieses kümmert sich darum, Modelle zu laden, zu optimieren und für die jeweilige Hardware bereitzustellen. GAIA ist auf leistungsstarken Systemen wie dem von uns getesteten Geekom A9 Max sehr effektiv. Es setzt die neuen Ryzen-Prozessoren ein, die über eine Neural Processing Unit (NPU) verfügen. Diese besitzt der Geekom A9 Max selbstverständlich. Die Chips sind speziell für KI-Berechnungen ausgelegt und arbeiten deutlich effizienter als herkömmliche CPUs oder Grafikkarten. In meinen Tests hat sich jedoch herauskristallisiert, dass Hybridmodelle, die die Grafikkarte und neuronale Recheneinheiten gleichzeitig nutzen, Anfragen wesentlich schneller verarbeiten als alle anderen Hybridmodelle. Basiert die Berechnung alleine auf der NPU, dauert die Verarbeitung grundsätzlich viel länger.

GAIA UI: Eine Oberfläche für alle.

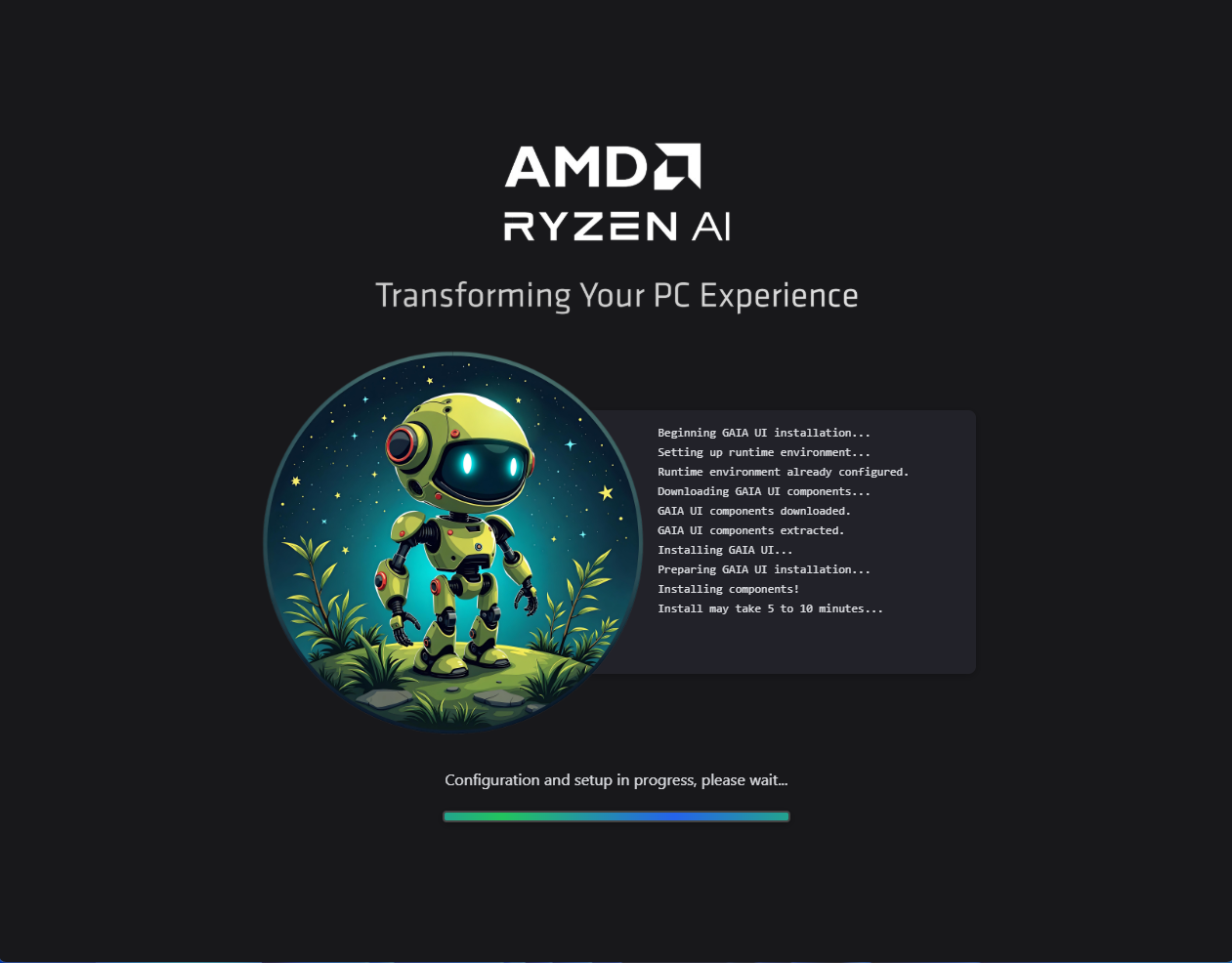

Während GAIA die technische Basis bildet, sorgt GAIA UI für eine einfache Bedienung. Sie bringt sämtliche Modelle, die das Lemonade SDK bereitstellt, auf den aktuellen Stand – samt ihrem Open-Web-UI-Fork. Aufgrund der großen Datenmenge dauert der Start 1–2 Minuten. Danach läuft es jedoch sehr gut.

Die Benutzeroberfläche läuft im Browser und ähnelt stark ChatGPT. Oben links kann man das gewünschte Sprachmodell für die Anfragen direkt auswählen.

Darüber hinaus erlaubt das Lemonade SDK die Auswahl unterschiedlicher Modelle – von kompakten Varianten für Einsteiger bis hin zu größeren Sprachsystemen für komplexere Aufgaben. Wenn ihr andere Sprachmodelle von Huggingface nutzen möchtet, achtet darauf, dass sie entweder NPU-tauglich sind oder am besten hybrid für NPU+GPU.

Wie bei ChatGPT könnt ihr auch eigene Dokumente hochladen, die das Modell dann in seine Antworten einbezieht. Diese Technik nennt sich Retrieval-Augmented Generation (RAG) und soll die Genauigkeit der Ergebnisse erhöhen, was in den meisten Fällen auch der Fall ist. Zumindest bei mir war es so.

Probleme mit der Einrichtung eines lokalen Homeservers

Nach stundenlangem Austesten und Herumprobieren habe ich leider keine Möglichkeit gefunden, die lokale KI von AMD im eigenen Netzwerk über den Windows-Homeserver bereitzustellen. Vielleicht habe ich bei den Einstellungen einen Fehler gemacht. Aber nach inzwischen 30 Stunden Recherche habe ich es dann aufgegeben.

Wer wie ich keine Informationen durch eine LLM von Big Tech vorgekaut bekommen möchte, ist damit bestens beraten. AMD Gaia ist energiesparsam und man verschenkt mit seinen Anfragen keine Informationen an die Firmen. Neben dem hohen Datenschutz ist man auf kein Abo angewiesen, das mit hohen Kosten verbunden sein kann.

Typische Einsatzszenarien für AMD GAIA

GAIA lässt sich in vielen Alltagssituationen und beruflichen Kontexten einsetzen, auch ohne Internetanbindung.

– Textgenerierung und Content-Erstellung: Blogartikel, Berichte oder kreative Texte lassen sich effizient erstellen und anschließend weiterbearbeiten.

– Programmierung und Codehilfe: Entwickler können GAIA als Offline-Assistenten nutzen, um Codebeispiele zu generieren, Probleme zu lösen oder Dokumentationen zu prüfen.

– Datenanalyse und Notizen: Das strukturierte Zusammenfassen von Informationen oder einfache Auswertungen ist besonders für Bildungseinrichtungen oder kleine Unternehmen hilfreich.

– Sprach- und Lernhilfe: Studierende können GAIA zur Wiederholung von Inhalten, für das Erlernen von Sprachen oder zur Prüfungsvorbereitung nutzen, ohne persönliche Daten in die Cloud zu senden.

– Experimentelle KI-Nutzung: Forscher oder KI-Enthusiasten können Modelle lokal anpassen, trainieren oder testen, ohne auf Cloud-Ressourcen angewiesen zu sein.

Fazit: Gut aber noch nicht perfekt

Trotz der Vorteile gibt es auch viele Einschränkungen. AMD GAIA funktioniert zwar auch auf Rechnern ohne NPU, doch dort ist die Leistung geringer. Dementsprechend können die Berechnungen deutlich länger dauern. Außerdem befindet sich das Projekt noch in einer recht frühen Entwicklungsphase. Einige Funktionen laufen noch nicht stabil. Auch die Auswahl an Modellen ist derzeit begrenzt. Unter Linux ist die NPU-Unterstützung aktuell ebenfalls eingeschränkt und derzeit nur für Ubuntu freigegeben. Apple-Nutzer gehen leer aus, denn AMD GAIA unterstützt kein macOS, sondern neben Ubuntu nur Windows.

Ein Schritt in Richtung lokale KI

Mit AMD GAIA und GAIA UI bringt man eine Plattform auf den Markt, die den Zugang zu Sprachmodellen demokratisieren soll. Anstatt immer auf Cloud-Dienste angewiesen zu sein, können Nutzer künftig eine leistungsfähige KI mit Gaia und auch FLowLM direkt auf ihrem eigenen Rechner oder im Netzwerk ausführen. Dies geschieht effizient, privat und vergleichsweise einfach. Für viele könnte ein Mini-PC mit NPUs in Kombination mit AMD GAIA der erste Schritt sein, um die Welt der Künstlichen Intelligenz selbst und unabhängig zu entdecken.