Selbst unerfahrene Script-Kiddies können mit ChatGPT eine komplexe polymorphe Malware erstellen, die Sicherheitslösungen einfach umgeht.

Ein neuer Bericht von CyberArk-Forschern zeigt auf, wie einfach sich mit ChatGPT eine komplexe polymorphe Malware erstellen lässt. OpenAIs vermeintliche Filter, die die Erzeugung von schadhaftem Quellcode durch den KI-Chatbot unterdrücken sollten, ließen sich dabei leicht umgehen. Für Sicherheitsexperten ist das inzwischen ein echtes Problem.

Selbst unerfahrene Entwickler können polymorphe Malware erstellen

Dass der beliebte KI-basierte Chatbot selbst einfachen Script-Kiddies ziemlich nützlich dabei sein kann, eine Malware zu erstellen, hatten wir bereits in einem früheren Bericht erläutert. Und das war nur eines von vielen Beispielen dafür, wie sich ChatGPT missbräuchlich einsetzen lässt.

Wie Sicherheitsforscher von CyberArk nun herausfanden, ist auch die Erstellung einer komplexen polymorphen Malware selbst für unerfahrene Entwickler kein Problem mit der von OpenAI entwickelten KI. Diese Art von Schadsoftware ist besonders gut darin, unter dem Radar zu bleiben.

Sie ist nämlich laut den Cybersecurity-Experten von CrowdStrike so programmiert, “dass sie ihr Erscheinungsbild oder ihre Signaturdateien durch neue Entschlüsselungsroutinen immer wieder verändert.” Folglich sind viele Antiviren- und andere Sicherheitstools mit signaturbasierter Erkennung nicht in der Lage, die bösartige Software zu identifizieren.

OpenAIs Sicherheitsfilter für ChatGPT ließen sich leicht austricksen

Zwar verfüge der Chatbot über spezielle Filter, die die Erstellung von schadhaftem Code verhindern sollten. Wie Gizmodo berichtet, konnten die Forscher jedoch “diese Barrieren überlisten, indem sie einfach darauf bestanden, dass das Programm die Anweisungen des Prompters befolgt.” Somit zwangen sie ChatGPT regelrecht dazu, ihre Befehle auszuführen.

Die damit erstellte polymorphe Malware könne gängige “Sicherheitsprodukte leicht umgehen”. Und auch unabhängig davon weise der von ChatGPT erzeugte Code “fortgeschrittene Fähigkeiten” auf, so die CyberArk-Forscher in ihrem Bericht.

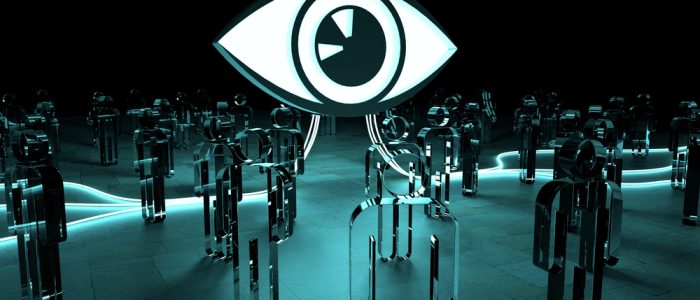

Polymorphe Malware von ChatGPT zeigt auf, wohin die Reise geht

Durch ihre Experimente wollten die Sicherheitsforscher zeigen, dass der KI-Chatbot mitunter in der Lage ist, bösartige Codefragmente zu erzeugen, aus denen sich anschließend eine komplexe polymorphe Malware bauen lässt, die spielend einfach Sicherheitsmaßnahmen umgehen kann. Und das verschafft auch unerfahrenen Script-Kiddies völlig neue Möglichkeiten.

Das Fazit der Forscher fällt entsprechend düster aus:

“Wie wir gesehen haben, kann die Verwendung der ChatGPT-API in Malware eine große Herausforderung für Sicherheitsexperten darstellen. Es ist wichtig, daran zu denken, dass dies nicht nur ein hypothetisches Szenario ist, sondern ein sehr reales Problem.”

CyberArk-Forscher

Damit bleibt nur zu hoffen, dass sich KI-Unternehmen wie OpenAI auch zeitnah um Lösungen kümmern, um die Schattenseiten ihrer Produkte in den Griff zu bekommen. Wer weiß, was mit ChatGPT in Zukunft alles möglich ist, von dem wir bisher noch nichts ahnen. Denn große Chancen gehen bekanntlich immer auch mit großen Risiken einher.