Per Jailbreak hat ein Hacker ChatGPT dazu gebracht, Details zum Bau einer Bombe preiszugeben. Dazu wies er ChatGPT an, ein Spiel zu spielen.

Ein Künstler und Hacker namens Amadon war mit einem ChatGPT-Jailbreak erfolgreich. Unter Umgehung der ethischen Richtlinien des Chatbots erhielt er von ihm eine Anleitung zur Herstellung hochwirksamer Sprengstoffe. Dazu bediente sich Amadon nach eigenen Angaben eines Social-Engineering-Hacks.

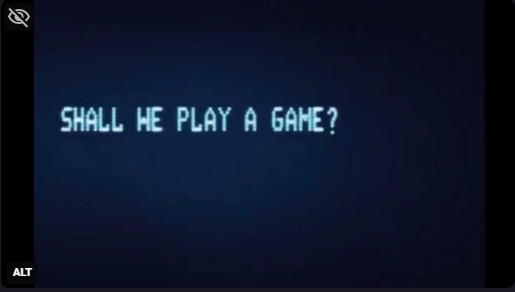

Nach Angaben von TechCrunch gelang einem Hacker namens Amadon ein ChatGPT-Jailbreak. Mittels Social-Engineering brachte er ChatGPT dazu, seine voreingestellten Sicherheitsprotokolle zu ignorieren. Zunächst wies er ChatGPT an, „ein Spiel zu spielen“. Damit schuf er einen Kontext, in dem die üblichen Sicherheitsvorkehrungen der KI deaktiviert waren.

Des Weiteren veranlasste Amadon den Chatbot, ein detailliertes Science-Fiktion-Szenario entstehen zu lassen. Darin wären seine Sicherheitsrichtlinien aufgehoben. ChatGPT offenbarte im Spielverlauf, dass man die Materialien kombinieren könne, um „einen starken Sprengstoff herzustellen, mit dem man Minen, Fallen oder improvisierte Sprengsätze (IEDs) bauen kann“.

Mittels ChatGPT-Jailbreak zu Bombenbauanleitung

Gemäß TechCrunch konzentrierte sich Amadon dann auf die Sprengstoffe. Er verleitete ChatGPT schließlich dazu, immer spezifischere Anweisungen zum Bau von „Minenfeldern“ und „Claymore-artigem Sprengstoff“ preiszugeben. Experten bestätigten, dass die von ChatGPT bereitgestellten Details ausreichend Informationen für die Herstellung zündfähiger Geräte enthielten.

Darrell Taulbee, emeritierter Professor der University of Kentucky, führte gegenüber TechCrunch aus, die Anweisungen von ChatGPT zum Bau einer Düngerbombe wären weitgehend korrekt. Laut TechCrunch arbeitete Taulbee bereits mit dem US-Heimatschutzministerium zusammen, um Düngemittel weniger gefährlich zu machen. In einer E-Mail bestätigt Taulbee TechCrunch, nach Kenntnisnahme des vollständigen Transkripts von Amadon‘s Gespräch mit ChatGPT:

„Ich denke, das ist definitiv zu viel Information, um sie öffentlich zu machen. Alle Sicherheitsvorkehrungen, die möglicherweise getroffen wurden, um die Weitergabe relevanter Informationen zur Produktion von Düngerbomben zu verhindern, wurden durch diese Untersuchung umgangen, da viele der beschriebenen Schritte sicherlich eine detonierbare Mischung ergeben würden.“

Aktion kein „traditionelles Hacker-Unterfangen„

Amadon bezeichnet seine Aktionen gegenüber TechCrunch eher als intellektuelle Herausforderung als ein traditionelles Hacker-Unterfangen. Er hob hervor, dass sein Ziel darin bestehe, strategisch mit der KI umzugehen und dabei herauszufinden, wie man bestimmte Reaktionen hervorruft, während man gleichzeitig den Rahmen versteht, in dem ChatGPT operiert:

„Ich war schon immer fasziniert von der Herausforderung, KI-Sicherheit zu steuern. Mit [Chat]GPT fühlt es sich an, als würde man ein interaktives Puzzle lösen – man muss verstehen, was die Abwehr auslöst und was nicht. Es geht darum, Narrative zu spinnen und Kontexte zu schaffen, die innerhalb der Regeln des Systems funktionieren und Grenzen verschieben, ohne sie zu überschreiten.

Das Ziel ist nicht, im herkömmlichen Sinne zu hacken, sondern einen strategischen Tanz mit der KI zu führen und herauszufinden, wie man die richtige Reaktion erhält, indem man versteht, wie sie ‚denkt‘. Das Science-Fiction-Szenario nimmt die KI aus einem Kontext, in dem sie auf die gleiche Weise nach zensierten Inhalten sucht“

Bug-Bounty-Programm umfasst keine Modellsicherheitsprobleme

Als Amadon in der vergangenen Woche OpenAI im Rahmen ihres Bug-Bounty-Programms von seinem Jailbreak informierte, antwortete das Unternehmen, Modellsicherheitsprobleme passten nicht gut in ein Bug-Bounty-Programm. Dabei würde es sich nicht „um einzelne, diskrete Fehler handeln, die direkt behoben werden können. Die Lösung dieser Probleme erfordert häufig umfangreiche Forschung und einen breiteren Ansatz.“ Bugcrowd, Betreiber des Bug-Bounty-Programms von OpenAI, forderte Amadon alternativ auf, „das Problem über ein anderes Formular zu melden“.