Hofft OpenAI auf milliardenschwere Aufträge von Militär und Regierungen? Eine Änderung in den Nutzungsrichtlinien lässt dies vermuten.

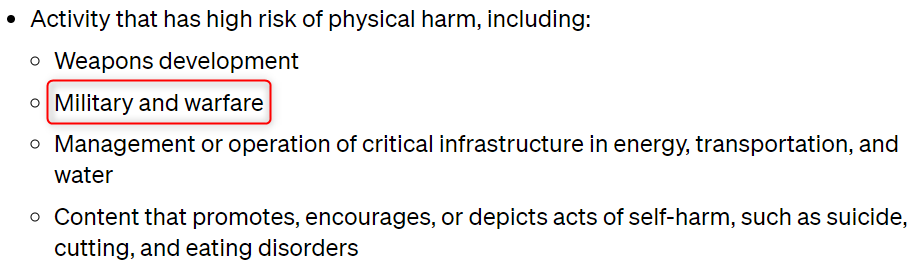

OpenAI hat seine Nutzungsrichtlinien aktualisiert und die explizite Verbotsklausel für die Nutzung seiner Technologie für „militärische und kriegerische Zwecke“ gestrichen. Diese Änderung, die am 10. Januar in Kraft trat, wirft Fragen über die Ausrichtung von OpenAI auf. Denn sie öffnet die Tür für eine mögliche Zusammenarbeit mit Militärbehörden weltweit.

Änderungen im Kleingedruckten: OpenAI lichtet den Nebel

Bis vor kurzem war es in den Nutzungsrichtlinien von OpenAI klar definiert. Die Nutzung der Technologie für militärische Zwecke war verboten. Jetzt, nach der jüngsten Überarbeitung, sind die Worte „Militär und Kriegsführung“ aus der Verbotsliste verschwunden. Der Grund dafür? Eine klarere Formulierung und das Hinzufügen von dienstspezifischen Hinweisen.

Die Folgen dieser Formulierungsänderung sind noch nicht absehbar. Aber sie kommt zu einer Zeit, in der Militärbehörden weltweit ein wachsendes Interesse an künstlicher Intelligenz zeigen. Die Entscheidung von OpenAI, die explizite Erwähnung von „Militär und Kriegsführung“ zu streichen, wirft ethische Fragen auf. Insbesondere angesichts der aktuellen Anwendung von KI-Systemen bei der gezielten Tötung von Zivilisten.

KI im Dienst des Militärs?

Die bisherige Verbotsklausel deutete darauf hin, dass OpenAI keine Zusammenarbeit mit Regierungsbehörden im militärischen Kontext anstrebt. Nun, da diese Einschränkung gelockert wurde, könnte dies die Tür für lukrative Angebote von Verteidigungsministerien weltweit öffnen. Dies berichtet Engadget in einem aktuellen Artikel.

Obwohl OpenAI derzeit keine Produkte für direkte physische Schäden anbietet, könnten seine Technologien indirekt in gefährlichen Kontexten eingesetzt werden. So z.B. bei der Erstellung von Code für eine potenziell schädliche Anwendung.

Ein Sprecher von OpenAI erklärte, dass die Änderung darauf abziele, universelle Prinzipien zu schaffen, die leicht zu merken und weltweit anwendbar seien. Grundsätze wie „Du sollst anderen keinen Schaden zufügen“ sollten weit gefasst, einfach verständlich und in verschiedenen Kontexten relevant sein. Es bleibt jedoch unklar, ob das Verbot, anderen „Schaden zuzufügen“, alle militärischen Anwendungen außerhalb der Waffenentwicklung umfasst.

Offene Türen und unklare Grenzen

Die jüngsten Änderungen in den Nutzungsrichtlinien von OpenAI werfen nicht nur Fragen über die Ausrichtung des Unternehmens auf. Sie öffnen auch Türen für potenzielle Kooperationen im militärischen Bereich. In einer Zeit, in der ethische Standards für KI-Technologien von großer Bedeutung sind, bleibt die Unklarheit über die genaue Reichweite des Verbots bedenklich.

Es muss abgewartet werden, wie OpenAI diese Entwicklung weiter kommuniziert und welche Auswirkungen sie auf die Nutzung seiner Technologien haben wird.