Benutzt ihr KI-Modelle wie DeepSeek? Dann findet jetzt heraus, wie LLMjacking-Angriffe diese LLMs und eure Daten bedrohen.

Cyberkriminelle haben ein neues Ziel: KI-Angriffe durch LLMjacking. Der Begriff „LLMjacking“ beschreibt eine Methode, bei der große Sprachmodelle (Large Language Models, LLMs) wie DeepSeek ins Visier genommen werden. Einer dieser Cyberangriffe auf KI-Modelle wurde nun ausführlich dokumentiert und zeigt, wie raffiniert die Angreifer dabei vorgehen.

Was verbirgt sich hinter LLMjacking?

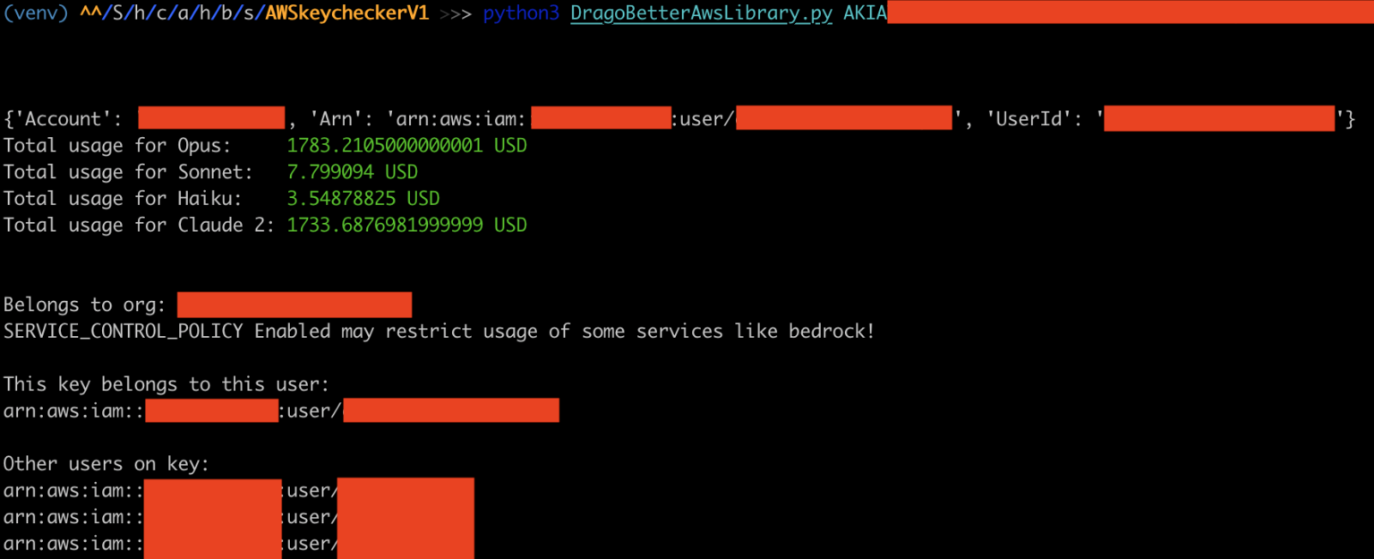

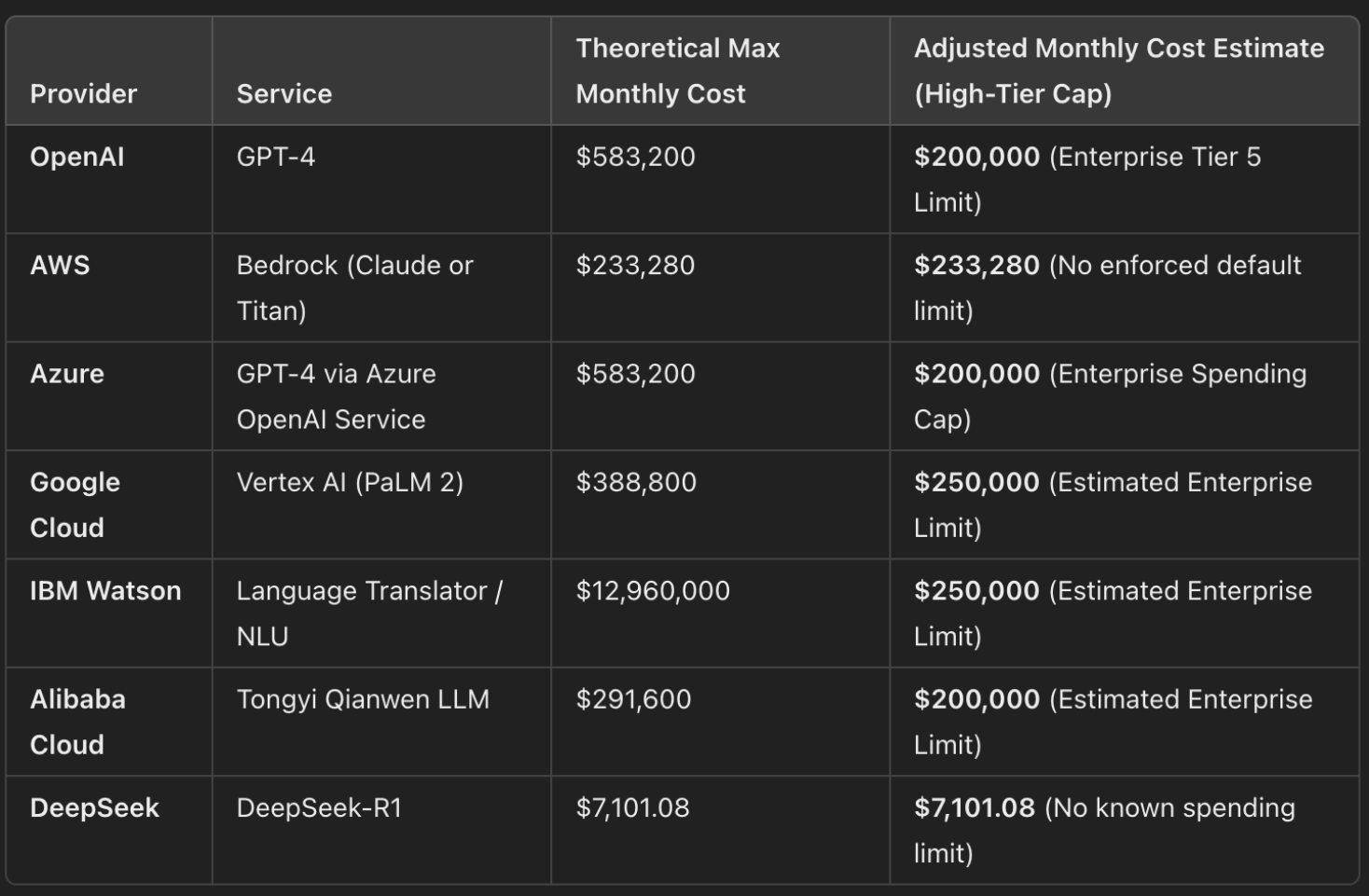

LLMjacking ähnelt dem digitalen Benzinklau, nur dass hier teure cloudbasierte KI-Dienste angezapft werden. Die Angreifer stehlen Zugangsdaten und verwenden leistungsstarke Sprachmodelle wie DeepSeek. Diese Modelle verbrauchen viel Rechenkapazität und treiben die Kosten für die Opfer in die Höhe.

Die Methode erinnert an klassische Cloud-Angriffe. Allerdings stehlen die Täter diesmal nicht Speicherplatz oder CPU-Leistung, sondern KI-Ressourcen. Die gestohlenen Daten fließen in eigene Projekte der Angreifer oder werden über dubiose Kanäle verkauft. Solche KI-Angriffe durch LLMjacking zeigen, wie vielseitig Cyberkriminalität KI-Modelle und deren Nutzer bedroht.

Cyberangriffe auf KI-Modelle: So gehen die Angreifer vor

Kriminelle stehlen API-Schlüssel oder Zugangsdaten aus früheren Cloud-Sicherheitsverletzungen oder durch Phishing-Angriffe auf KI-Nutzer. Bei einem Phishing-Angriff auf Nutzer von KI-Diensten senden Angreifer gefälschte E-Mails oder Nachrichten, die vertrauenswürdig erscheinen.

Diese Nachrichten enthalten häufig Links zu gefälschten Anmeldeseiten. Ahnungslose Nutzerinnen und Nutzer geben dort ihre Zugangsdaten ein. Mit diesen Daten verschaffen sich die Kriminellen Zugang zu den Modellen. Sie missbrauchen die Rechenleistung für eigene Projekte wie die Erstellung von Inhalten oder das Training neuer Modelle.

Die Angreifer handeln schnell, sobald ein neues KI-Modell auftaucht. Sysdig berichtet von verdächtigen Aktivitäten unmittelbar nach der Veröffentlichung von DeepSeek. Solche LLMjacking-Angriffe auf Sprachmodelle zeigen, wie organisiert und professionell diese kriminellen Gruppen arbeiten.

Die Bedrohung wächst

Mit dem zunehmenden Einsatz von KI in Unternehmen steigt auch das Interesse von Cyberkriminellen. LLMjacking Angriffe auf KI-Modelle wie DeepSeek sind nur ein Beispiel dafür. Künstliche Intelligenz ist nicht mehr nur ein Werkzeug für Verteidiger, sondern auch ein Angriffsziel. Und eines ist klar. Cyberangriffe auf KI-Modelle werden in Zukunft weiter zunehmen, wenn Unternehmen keine geeigneten Schutzmaßnahmen ergreifen.

Unternehmen müssen jetzt handeln. Der Schutz von Zugangsdaten und API-Schlüsseln ist der erste wichtige Schritt. Unternehmen sollten verdächtige Aktivitäten kontinuierlich überwachen. Darüber hinaus sind Sicherheitskonzepte wie Zero-Trust-Architekturen oder Multi-Faktor-Authentifizierung unerlässlich. Ob die Unternehmen diesbezüglich aktiv werden, bleibt abzuwarten.

LLMjacking Angriffe auf KI-Modelle – das Katz und Maus Spiel hat begonnen

LLMjacking sollte ein Weckruf für die gesamte IT-Branche sein. Die Bedrohungslage verändert sich rasant. Künstliche Intelligenz wird zur neuen Frontlinie im digitalen Katz-und-Maus-Spiel. Die Manager der Unternehmen müssen ihre Sicherheitsstrategien überdenken und beginnen, die Risiken von KI-basierten Diensten ernst zu nehmen.

Denn eines ist sicher: Die Angreifer bleiben aktiv! Es ist an der Zeit, Sicherheitslücken zu schließen, bevor der nächste Angriff wieder die Oberhand gewinnt.