Neue Schwachstellen in ML-Toolkits: Sicherheitslücken erhöhen das Risiko von Angriffen auf ML-Systeme durch KI-Hacker.

Die rasante Entwicklung im Bereich des maschinellen Lernens bringt nicht nur Innovationen, sondern auch neue Sicherheitsrisiken mit sich. KI-Hacker dürften sich freuen. Jüngste Untersuchungen haben besorgniserregende Schwachstellen in sehr vielen beliebten Open-Source-ML-Toolkits aufgedeckt. Die neuen Erkenntnisse werfen jetzt ein kritisches Licht auf die Sicherheit der aktuellen und zukünftigen KI-Entwicklung.

Die Abkürzung „ML“ steht übrigens für den englischsprachigen Begriff Machine Learning. Maschinelles Lernen entwickelt, untersucht und verwendet sogenannte Lernalgorithmen. Diese können Lösungen für Probleme lernen, die zu kompliziert sind, um sie mit Regeln zu beschreiben, zu denen es aber viele Daten gibt, die als Beispiele für die gewünschte Lösung dienen können.

Sicherheitslücken in ML-Toolkits erschüttern ML-Community

Sicherheitsforscher des Softwareunternehmens JFrog haben eine beeindruckende Entdeckung gemacht. Sie fanden kritische Sicherheitslücken in fast zwei Dutzend populären Open-Source–Toolkits für maschinelles Lernen. Betroffen sind bekannte Projekte wie Weave, ZenML, Deep Lake, Vanna.AI und Mage AI. Die Schwachstellen erstrecken sich über Client- und Serverkomponenten und öffnen potenziellen Angreifern Tür und Tor.

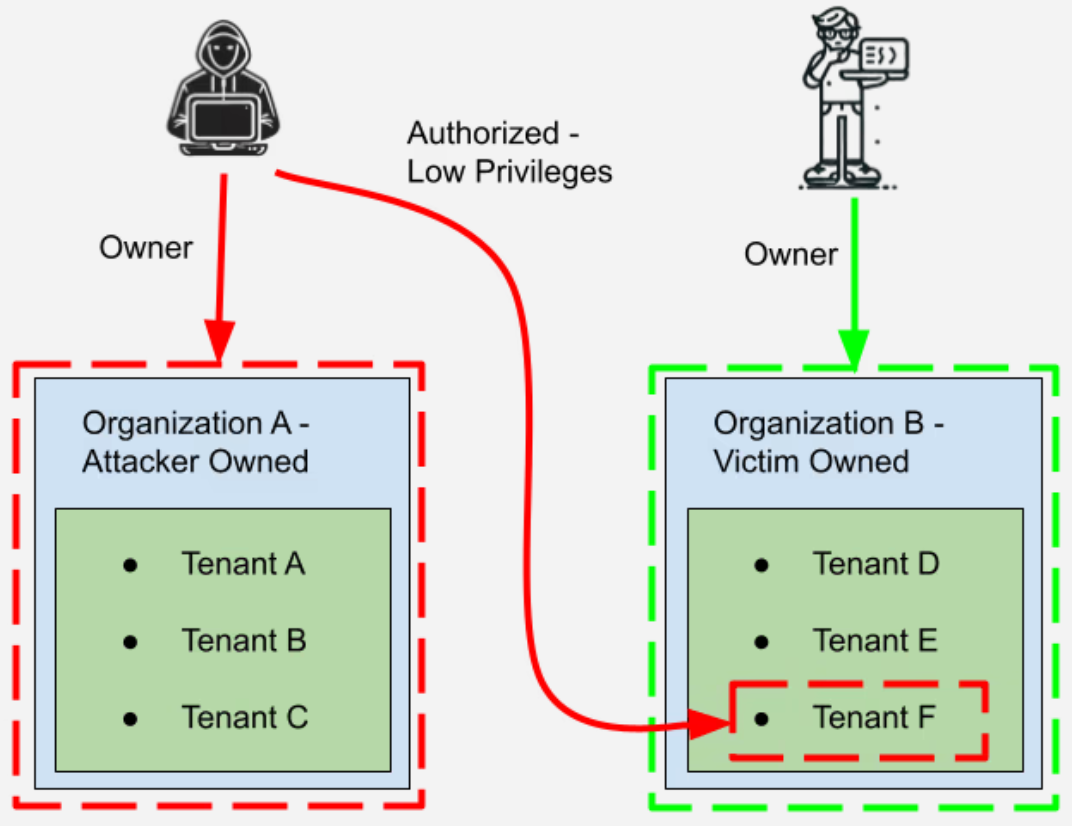

Von besonderer Brisanz ist die Schwachstelle CVE-2024-7340 im Weave Toolkit. Sie ermöglicht es Angreifern mit geringen Zugriffsrechten, Administratorrechte zu erlangen. Im Deep Lake Toolkit wurde die Schwachstelle CVE-2024-6507 entdeckt, die das Einschleusen von Befehlen über manipulierte Dateiuploads ermöglicht. Auch die KI-Bibliothek Vanna.AI und das Mage AI-Framework weisen gefährliche Schwachstellen auf, die sogar eine Remotecodeausführung ermöglichen.

Die Auswirkungen dieser Sicherheitslücken in ML-Toolkits sind für Unternehmen, die auf diese Open-Source-Lösungen setzen, besonders schwerwiegend. Denn ein erfolgreicher Angriff kann die gesamte MLOps-Pipeline gefährden. MLOps-Pipelines, die Daten und Modelle verarbeiten und veröffentlichen, sind oft das Herzstück der KI-Infrastruktur eines Unternehmens.

Wird eine Schwachstelle ausgenutzt, können Angreifer MLOps-Prozesse wie die Modellregistrierung oder die Datenanalyse infiltrieren und damit das Training und die Implementierung von Modellen gefährden. Dies berichtet The Hacker News in einem aktuellen Artikel.

Schutz vor ML-Sicherheitslücken: Ansätze und Maßnahmen

JFrog warnt eindringlich vor möglichen Angriffen auf die Sicherheitslücken in den ML-Toolkits und hat die betroffenen Schwachstellen zur Behebung an die Entwickler weitergeleitet. Aber auch nach der Veröffentlichung eines Sicherheitsupdates liegt es in der Verantwortung der Nutzer, diese konsequent einzuspielen.

Das Sicherheitsframework „Mantis“ bietet einen neuen Ansatz zur Abwehr von Cyberangriffen und zeigt, wie zeitbasierte Abwehrmechanismen das Risiko für LLMs reduzieren können. Durch die präzise Platzierung von Eingaben soll Mantis das System des Angreifers irritieren und im besten Fall seine Aktionen stoppen.

Fazit

Die Entdeckung dieser Sicherheitslücken zeigt sehr schön, aber auch nachdrücklich, vor welchen Herausforderungen die Open-Source-Gemeinschaft im Bereich des maschinellen Lernens steht. Sicherheitslücken in ML-Toolkits stellen ein erhebliches Risiko für Unternehmen dar, die auf Open-Source-Lösungen setzen. Der Umgang mit diesen Schwachstellen muss konsequent und schnell erfolgen, um die Integrität der eingesetzten Systeme und den Schutz sensibler Daten zu gewährleisten.