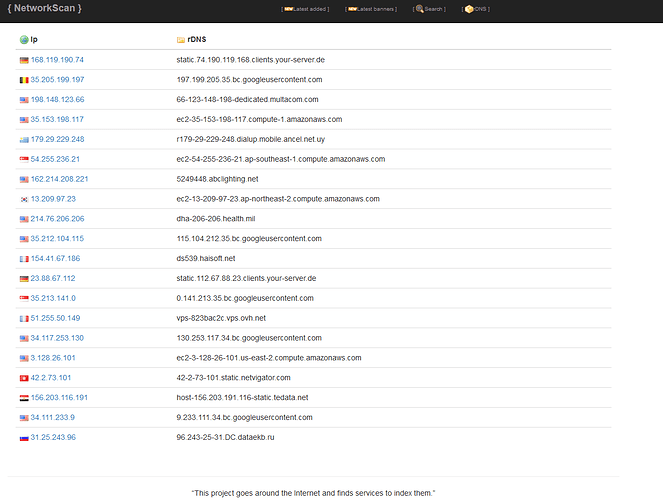

Dieses Projekt geht durch das Internet und findet Dienste, um sie zu indizieren.

Ich finde, die Suchmaschine von Censys, ist bei der Aufbereitung der Daten, z.B. bei der Sortierung besser aufgestellt… ![]()

Du meinst die hier, gell? https://search.censys.io

Jap… ![]()

Bei Networkscan kann man wohl nur nach IP’s crawlen. Bei Censys ist es völlig egal, welche Werte du schon besitzt - die Maschine sucht es! Genauso auch über jeglich erdenkliche Kombination von Werten zu einem Querie!

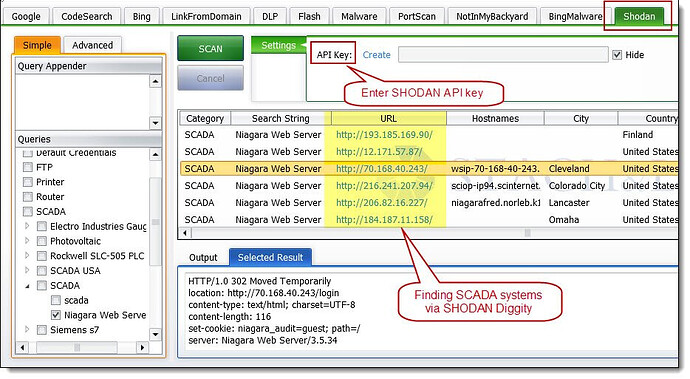

Im Endeffekt identisch mit Shodan…nur das beide Dienste halt auf unterschiedlichen Such-Algorithmen basierend aufgebaut sind.

Mit Shodan hat wohl jeder mal angefangen, der sich mit der Thematik auseinandersetzt. Für beide Dienste existiert eine Search-String Language, die sehr umfangreich ist. Ich hab da mal 2009 / 2010 mit angefangen, später mit Shodan Diggify

…und anfänglich natürlich mit „Complete Guide to Shodan Collect. Analyze. Visualize. Make Internet Intelligence Work for You“

https://support.censys.io/hc/en-us/articles/360059720271-Search-2-0-Example-Host-Queries

https://github.com/thehappydinoa/awesome-censys-queries ![]()

https://5851803.fs1.hubspotusercontent-na1.net/hubfs/5851803/Censys_Data_Whitepaper_2021.pdf

More Internet hosts and services:

Automatic protocol detection, where Censys identifies services

independently of ports, means your team will have visibility into

services running on non-standard ports. We perform automatic

protocol detection to find services running on unexpected ports,

where 66% of the services we uncover are on non-standard ports

Multi-perspective scanning:

By scanning from five Tier-1 Internet Service Providers from

separate locations around the globe, with Censys data you

have visibility of 99% of active IPv4 hosts on the Internet.

Censys maintains the largest X.509 certificaterepository in the world:

- containing 9.5 billion certificates.

• Certificates originate from both Certificate

Transparency Logs and from TLS handshakes of

IPv4 hosts.

• Complete and parsed certificate details with

browser trust status

Netlas is pretty good as well

es reicht auch eine nmap mit erweiterten optionen…

Die IP`s solcher automatisierten Datenkraken lassen sich recht simpel blockieren.![]()

Gibt massig Scripts für Iptables & Co. auf Github zu finden, welche neugiere Anfragen auf TCP/UDP Ports der Datenkraken am eigenen Inet-Server komplett filtern können❗

Das mag ja sein. Aber wie @anon68823658 schon sagte, reicht z.B. auch ein „nmap“ aus, welches ich von zuhause oder von einem eigenen externen Server aus, ausführen kann. Ich glaube nämlich nicht, dass diese IPs dann ebenfalls geblockt werden - zumindest nicht beim ersten Scan!

dafür gibt es fail2ban ![]()

Warum wusste ich, dass nun „fail2ban“ kommt?! ![]()

Beschreibung:

Der Hauptzweck von fail2ban ist das Bestimmen und Blockieren bestimmter IP-Adressen, die wahrscheinlich zu Angreifern gehören, die sich Zugang zum System verschaffen wollen. fail2ban ermittelt aus Log-Dateien (u. a. /var/log/pwdfail, /var/log/auth.log oder /var/log/apache2/error.log) IP-Adressen, die in einem vom Administrator angesetzten Zeitrahmen z. B. öfter versuchen, sich mit falschen Passwörtern anzumelden oder andere gefährliche oder sinnlose Aktionen ausführen.

Ich weiß aber auch, dass fail2ban nicht das Allheilmittel ist, was bei einem ersten Scan, die korrekte Aktion ausführt, um öffentliche „saubere“ IPs zu blocken - eher bei einem zweiten Versuch etc.

Auch dann nicht, wenn ich mir zuvor die Finger wund konfiguriere, um die „false/positives“ so gering wie möglich zu halten.

Ich konfiguriere meine Firewall und schließe Ports, prüfe das mit nmap nach, ob da auch wirklich für die öffentlichkeit verschlossen ist und mit censys schaue ich, ob die vhosts offen rumliegt.

Das ist ja auch völlig legitim und korrekt bei der Prüfung eigener Server! Aber @dach_forum meinte ja die externe Prüfung von fremden Büchsen… ![]()

Ich hab nie von einer externen Prüfung von fremden Büchsen geschnattert, sondern dass man seine eigenen Kisten vor Datenkraken effektiv schützen kann.![]() Zum Bleistift mit einer richtig konfigurierten Firwewall oder Fail2Ban etc. etc… etc… Und auf Github gibt es wie gesagt massig fertige Scripts dafür.

Zum Bleistift mit einer richtig konfigurierten Firwewall oder Fail2Ban etc. etc… etc… Und auf Github gibt es wie gesagt massig fertige Scripts dafür.![]()

Und das kommt beim Ergebnis nicht aufs Selbe raus? Letzten Endes geht es doch nur um eine Strategie dazu! ![]()